具身智能中的Sim2Real迁移问题

社会变迁中,移民问题日益突出 #生活知识# #社会生活# #社会变迁#

具身智能中的Sim2Real迁移问题-多模态建模与策略优化视角

引言

具身智能(Embodied Intelligence)是人工智能领域的重要分支,强调感知-思考-行动闭环,通过真实或虚拟身体与环境互动来实现智能。当前,如何使具身智能体具备多模态感知(视觉、听觉、触觉等)并进行高效决策,是一项前沿且复杂的研究课题。

本文将从具身智能的多模态感知融合、决策机制构建入手,分析其面临的关键技术挑战,并结合一个PyTorch代码实例,展示感知与决策的一体化管线,最后展望未来发展方向。

一、具身智能的核心概念与技术架构

1.1 什么是具身智能?

具身智能指的是一种体现在物理环境中,能够进行感知、理解、学习并执行行为的智能体系统。其典型代表包括:

家庭服务机器人 自动驾驶车辆 虚拟人游戏代理(如AI NPC)

1.2 技术架构概览

具身智能一般由以下模块组成:

感知模块(Perception):处理来自摄像头、麦克风、传感器的数据; 融合模块(Multimodal Fusion):整合不同模态的数据形成语义向量; 决策模块(Policy/Planner):根据语义向量进行动作选择; 执行模块(Control):将动作指令转化为物理运动。二、多模态感知的挑战与方法

2.1 多模态感知面临的挑战

数据对齐困难:图像和语音在时间维度与语义维度上不一致; 数据异构性强:不同模态的数据维度和特征差异巨大; 感知与动作延迟:实时系统要求低延迟,但多模态数据处理代价高。2.2 融合技术现状

目前主流的多模态融合方法如下:

方法 简述 优点 缺点 早期融合(Early Fusion) 特征级拼接 简单直观 对齐要求高 后期融合(Late Fusion) 决策级合并 模型可独立训练 模态间协同性差 协同注意力融合(Co-attention) 互相注意机制 表达能力强 参数多,训练难度大2.3 示例:融合视觉与语音信号

以下是一个融合图像和语音的简单PyTorch模型,用于导航任务中的目标识别:

import torch import torch.nn as nn import torchvision.models as models class MultimodalEncoder(nn.Module): def __init__(self): super().__init__() self.vision_backbone = models.resnet18(pretrained=True) self.vision_backbone.fc = nn.Identity() # 去掉最后分类层 self.audio_encoder = nn.Sequential( nn.Linear(128, 256), nn.ReLU(), nn.Linear(256, 512) ) self.fusion = nn.Sequential( nn.Linear(512 + 512, 512), nn.ReLU(), nn.Linear(512, 256) ) def forward(self, image, audio_feat): vision_feat = self.vision_backbone(image) # [B, 512] audio_feat = self.audio_encoder(audio_feat) # [B, 512] fused = torch.cat([vision_feat, audio_feat], dim=1) # [B, 1024] out = self.fusion(fused) # [B, 256] return out

该模型提取图像特征(视觉)与语音嵌入(听觉),并在融合后用于后续任务(如目标选择、路径规划等)。

三、具身决策机制:从强化学习到大模型控制

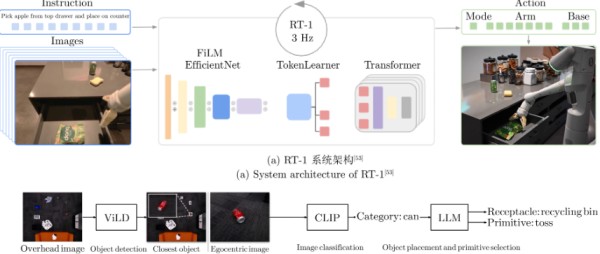

3.1 决策模型的发展

基于规则的规划器(FSM, A*, SLAM) 基于强化学习的策略网络(DRL) 大模型控制(LLM+RLHF)3.2 强化学习与具身智能结合

具身智能中广泛使用**强化学习(Reinforcement Learning)**训练代理从环境中学习行为策略。例如,基于PPO算法控制一个导航智能体:

import gym from stable_baselines3 import PPO env = gym.make("FetchReach-v1") # 模拟机械臂环境 model = PPO("MlpPolicy", env, verbose=1) model.learn(total_timesteps=100000) obs = env.reset() for _ in range(100): action, _ = model.predict(obs) obs, reward, done, info = env.step(action) env.render()

这种方式能够在模拟环境中学习复杂的动作序列,例如操纵、抓取等。

四、未来发展前景与技术趋势

4.1 多模态大模型将驱动具身智能飞跃

随着OpenAI GPT-4o、Google Gemini等多模态大模型的崛起,我们正在进入“通用感知-决策一体化智能体”时代。它们具备:

文本、图像、语音统一的理解能力; 可泛化至多任务的推理能力; 可以从自然语言指令中执行任务。4.2 与物理世界更深融合

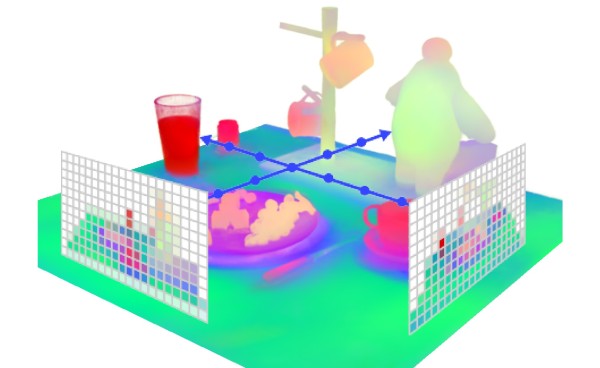

真实世界感知与仿真数据对齐 数据增强与Domain Randomization技术 具身图文理解(Embodied VQA)4.3 低成本部署挑战与解决方案

微型模型蒸馏与剪枝 多模态小模型蒸馏自大模型(如MiniGPT) 利用边缘计算平台(如Jetson Nano)

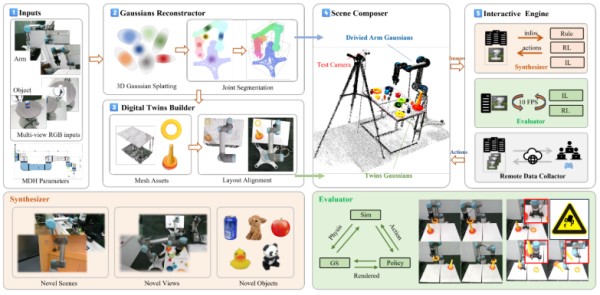

五、具身智能的训练平台与模拟环境

5.1 常用模拟平台对比

具身智能需要大量交互数据训练决策模型,因此模拟环境是不可或缺的基础设施。以下是几种主流模拟器及其特点:

平台 优点 缺点 适用场景 AI2-THOR 场景丰富(厨房、卧室等),支持交互 场景构建相对固定 家庭场景导航 Habitat 高性能、逼真渲染、支持Nav任务 初学者配置复杂 室内视觉导航 Gibson / iGibson 拥有真实扫描数据,物理交互强 配置资源消耗大 高保真物理仿真 Webots / IsaacSim 可用于机器人部署前的仿真 模型移植成本高 工业机器人与操作5.2 示例:使用Habitat进行具身导航训练

以下是一个使用Habitat训练智能体在室内环境中完成目标导航任务的流程简述:

from habitat_baselines.run import run_exp # 配置文件包括场景路径、传感器设置(RGB、Depth、GPS)等 config_path = "configs/tasks/pointnav_mp3d.yaml" # 启动训练任务(支持PPO、DD-PPO等策略) run_exp(["--run-type", "train", "--exp-config", config_path])

训练完成后,可利用测试脚本生成导航轨迹、评估成功率(SR)、SPL等指标。这些指标是具身智能性能的重要度量。

六、具身智能在真实机器人中的部署

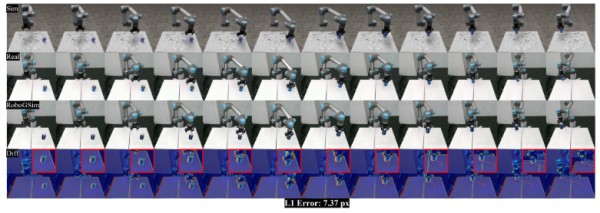

6.1 从仿真到现实(Sim2Real)迁移

尽管在仿真中可以轻松训练复杂策略,但将其部署到真实机器人仍面临挑战:

感知偏差(传感器误差 vs 仿真图像); 动力学差异(物理建模精度); 执行时延(真实系统具有通信与控制延迟);为此,研究者提出了Sim2Real迁移技术,如:

Domain Randomization(领域随机化):增强模型鲁棒性; Adversarial Domain Adaptation(对抗式域适配); Real2Sim Calibration(真实数据反哺仿真)。6.2 示例:JetBot上的视觉控制任务部署(Jetson Nano)

以NVIDIA JetBot为例,一个基于Jetson Nano平台的低成本机器人,可实现具身视觉控制:

# 控制JetBot沿图像中的线条移动(简化版) from jetbot import Robot, Camera import torch import torchvision.transforms as transforms from PIL import Image robot = Robot() camera = Camera.instance() model = torch.load('line_follower_model.pth') model.eval() transform = transforms.Compose([ transforms.Resize((224, 224)), transforms.ToTensor() ]) def control_loop(): image = camera.value input_tensor = transform(Image.fromarray(image)).unsqueeze(0) output = model(input_tensor) steer = output[0][0].item() speed = output[0][1].item() robot.set_motors(steer + speed, -steer + speed) while True: control_loop()

这类机器人验证了从视觉到控制的端到端部署路径,适合教育、原型验证等低成本场景。

七、未来研究方向与技术趋势

7.1 通用任务学习(Generalist Agent)

OpenAI提出的GPT-4o,以及Google的RT-X、DeepMind的Gato,正在推动“通才型智能体”的发展。具身智能也将逐步从“一个模型解决一个任务”走向“多任务统一模型”。

未来趋势包括:

多模态统一Token建模:统一图像、文本、触觉编码; 语言驱动具身行动(Language as Policy):通过自然语言控制行为; 因果推理能力集成:提升对复杂物理世界的推断能力;7.2 强化学习 + 大语言模型融合(RLHF for Embodiment)

将大型语言模型(LLMs)引入具身决策系统,核心优势在于:

具备上下文理解能力,可解释任务意图; 可通过人类反馈进行微调(Reinforcement Learning from Human Feedback); 可在语言空间中进行“规划-推理-执行”联动。例如,使用语言模型对低层策略的输出进行语义约束:

# 使用语言模型对具身策略决策进行过滤 prompt = "If the robot sees a red cup and hears 'pick it up', what should it do?" response = openai.ChatCompletion.create( model="gpt-4", messages=[ {"role": "system", "content": "You are a robot controller."}, {"role": "user", "content": prompt} ] ) print(response['choices'][0]['message']['content'])

这为复杂任务中的高层语义理解提供了新范式。

结语

具身智能的未来取决于我们能否构建通感知、能决策、可执行的智能体系统。其核心是多模态感知与策略融合,从图像、声音到语言的整合理解,是构建类人智能的关键。未来,随着大模型和自主决策的进一步结合,真正能够“看懂世界并做出行动”的智能体,将不再只是实验室里的产物。

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱: cloudbbs@huaweicloud.com

网址:具身智能中的Sim2Real迁移问题 https://www.yuejiaxmz.com/news/view/1041336

相关内容

新旧项目升级下的数据库数据迁移问题什么是迁移学习?迁移学习的场景与应用

迁移学习精要

Win11软件搬家指南:五步轻松解决迁移难题

迁移指南

心理学专业知识技能可迁移技能自我管理技能

软件迁移=重复造轮子?不重写代码如何完成迁移

为迁移而教(现实生活应用型学习设计指南)/迁移教学译丛

善用“倾听”——浅谈心理咨询技术在学生管理工作中的迁移

户口迁移网上怎么办理流程