告别熬夜搜文献!我用 Gemini 造了个 2 分钟出深度研究报告的 AI 神器!

用Google学术搜索学术论文和研究报告 #生活技巧# #学习技巧# #在线学习资源推荐#

平时呢,我就喜欢琢磨各种技术,不光是看它表面怎么用,更爱挖挖它底层的原理,想想怎么用这些技术来解决咱们工作、生活里遇到的实际问题。比如,大家是不是跟我一样,经常为了写个报告、做个方案,或者就是单纯想深入了解某个新领域,需要查阅大量的资料?

打开搜索引擎,关键词输进去,哗啦啦出来几十页结果,眼睛都看花了。好不容易找到几篇相关的,还得一篇篇读,筛选信息、整理思路、最后汇总成文... 这一套流程下来,少则半天,多则几天,效率低不说,还特别熬人。尤其是在这个信息爆炸的时代,我们缺的不是信息,而是快速从海量信息中提取、加工、并形成深度见解的能力。

我就在想,这事儿能不能让 AI 来帮忙干呢?能不能有个工具,我告诉它我想研究啥,它就能像个经验丰富的研究员一样,快速帮我把相关的靠谱信息搜集、整理、分析,最后直接给我一份结构清晰、内容深入的报告?

于是,捣鼓了一段时间,Deep Research[1] 这玩意儿就诞生了!开源的,随便改造为自己需要的。

简单来说,Deep Research 就是一个基于 Google 最新的 Gemini AI 模型,能在短短 2 分钟左右,帮你生成一份相当有深度的研究报告的开源工具。 是的,你没听错,就是这么快!

听起来是不是有点小激动?别急,让我跟你详细唠唠这东西有啥能耐,又是怎么实现的。

Deep Research 有哪些看家本领?1. 快!准!狠!2 分钟出报告:这绝对是核心亮点。利用 Google Gemini 的强大能力和联网搜索功能,它能迅速抓取、理解、整合信息,大大压缩了传统研究需要的时间。原来可能要耗费数小时甚至数天的工作,现在一杯咖啡的功夫就搞定了。

2. Gemini 加持,智能分析:咱们用的是 Google 家最新的 Gemini 系列模型(比如功能强大的 "Thinking" 模型和速度更快的 "Flash" 模型,你可以根据需要切换),这些模型在理解复杂问题、进行推理和生成高质量文本方面都相当出色,保证了报告的深度和准确性。

3. 隐私第一,数据本地存:这点我特别看重!你的研究主题、过程数据、生成的报告,默认情况下全部存储在你自己的浏览器本地。除非你选择使用服务器模式(后面会讲),否则数据根本不会离开你的电脑,绝对安全放心。

4. 报告还能“微调”:生成的报告不完全满意?没关系!我们内置了一个 Canvas 编辑器,支持两种模式:一种是“所见即所得”(WYSIWYM,更注重内容结构),另一种是大家熟悉的 Markdown。你可以直接在上面修改内容。更贴心的是,你还可以调整报告的阅读难度等级、文章长度,甚至进行全文翻译!满足各种场景需求。

5. 历史记录,随时回顾:做过的研究都会保存下来,方便你随时回头查看,或者在之前的基础上进行二次深入研究。不用担心灵感或重要发现丢失。

6. 部署灵活,在哪都能跑:想自己部署?没问题!你可以一键部署到 Vercel、Cloudflare Pages 这类流行的 Serverless 平台,也可以用 Docker 在自己的服务器或者本地运行。当然,最简单的就是在你自己的电脑上本地运行开发模式。

7. 多语言支持:目前支持英文和咱都看得懂的简体中文。

8. 现代技术栈:用了最新的 Next.js 15 和 Shadcn UI,保证了性能和颜值都在线,用起来流畅又舒服。

9. 完全开源,免费使用:项目遵循 MIT 协议,代码完全开放,你可以自由使用,无论是个人研究还是商业用途,都没问题。欢迎大佬们一起来添砖加瓦!

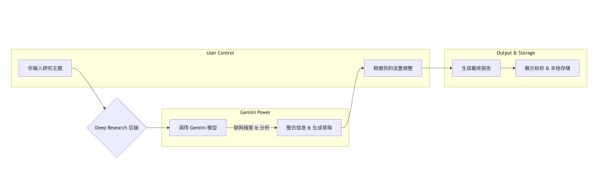

它是怎么做到这么快的?你可能好奇,这 2 分钟背后到底发生了啥?虽然不能透露所有商业机密(开玩笑的,开源项目哪有啥商业机密 ),但基本原理是这样的:

1. 理解你的需求:你输入想研究的主题。

2. 智能规划与搜索:Deep Research 会分析你的主题,然后利用 Gemini 模型的联网能力,去互联网上查找最相关、最权威的信息源。它不是简单地把搜索结果丢给你,而是会理解这些信息。

3. 深度分析与整合:Gemini 模型会对搜集到的信息进行阅读、理解、筛选、提炼和总结,找出其中的关键点、联系和逻辑。这里可能用到了像 "Thinking" 这样更侧重深度思考的模型。

4. 报告生成与优化:最后,模型会把分析结果组织起来,按照一定的结构(比如引言、关键发现、细节分析、结论等)生成一份结构清晰、语言流畅的报告草稿。如果你设置了特定的阅读等级或长度,它还会进行相应调整。

5. 快速交付:整个过程被高度优化,特别是利用了 Gemini 的 "Flash" 等快速响应模型以及可能的并行处理,才能在约 2 分钟内完成。

和其他工具比,Deep Research 有啥不一样?市面上也有不少信息获取和处理工具,咱们来简单对比一下:

特性

Deep Research

手动搜索 + 人工整理

普通搜索引擎 (Google/Bing)

通用聊天机器人 (ChatGPT/Gemini Web)

速度极快 (约 2 分钟出报告)

慢 (数小时到数天)

快 (秒级出链接)

较快 (对话式生成)

深度较深 (AI 整合分析)

可深可浅 (取决于投入)

浅 (仅提供链接)

中等 (依赖 Prompt 和模型能力)

报告质量结构化,接近成品

质量高度依赖个人能力

无报告

对话形式,需自行整理

专注度高度聚焦研究主题

可能分心

可能被广告/无关信息干扰

可能跑题

隐私性极高 (默认本地存储)

高 (本地操作)

低 (搜索记录被追踪)

中 (数据可能用于训练)

易用性简单 (输入主题即可)

复杂 (需多种技能)

简单

简单 (对话式)

成本开源免费 (需自备 Gemini API Key)

时间成本高

免费

部分免费,高级功能收费

简单来说,Deep Research 像是给你配了个专业的 AI 研究助理,专门负责快速完成信息搜集和初步报告撰写的脏活累活。

想上手试试?跟我来!心动不如行动,想跑起来也挺简单:

1. 准备工作:搞定 Gemini API Key

这工具的核心是 Google Gemini,所以你需要一个 Google AI 的 API Key。

• 访问 Google AI Studio[2] (可能需要科学上网)。

• 登录你的 Google 账号。

• 创建一个新的 API Key。把这个 Key 复制下来,保存好,别泄露出去!

2. 最快体验:一键部署 (推荐 Vercel)

如果你有 Vercel 账号(免费的就行),可以直接点击项目 README 里的 "Deploy with Vercel" 按钮,跟着提示操作,几分钟就能拥有一个在线的、你自己专属的 Deep Research 服务!部署时它会让你填入你的 Gemini API Key。

3. 本地运行 (适合开发者)

如果你想在自己电脑上跑,或者想研究下代码:

• 环境准备:

• 安装 Node.js[3] (建议 v18.18.0 或更高版本)。

• 安装 pnpm (推荐) 或 npm/yarn 包管理器。

• 开搞:git clone https://github.com/u14app/deep-research.git

cd deep-research

pnpm install

在项目根目录创建一个 .env 文件,内容类似这样:# Google Gemini API Key (本地模式运行时,这个*不是*必须的, 但服务器模式需要)

# 如果你有多把 Key,用英文逗号隔开,如 key1,key2,key3

GOOGLE_GENERATIVE_AI_API_KEY=你的Gemini_API_Key放这里

# (可选) API 代理地址,如果你需要通过代理访问 Google API

# API_PROXY_BASE_URL=https://your.proxy.com

# (可选) 访问密码,给你的部署增加一层保护

ACCESS_PASSWORD=设置一个你的访问密码

# (可选) 注入统计或错误跟踪脚本

# HEAD_SCRIPTS=<script>...</script>

重点来了:如果你只是想在自己电脑上用本地模式跑,GOOGLE_GENERATIVE_AI_API_KEY 其实可以不填在 .env 文件里!你可以在 Deep Research 的界面上直接输入你的 Key,这样 Key 就只存在你的浏览器里,更加私密。.env 文件里的配置主要是给服务器端 API 调用或者部署时使用的。ACCESS_PASSWORD 是你部署后,防止别人滥用你的服务的密码。 • 启动!# 运行开发模式

pnpm dev

• 打开浏览器,访问 http://localhost:3000,你的本地 Deep Research 就跑起来啦!

4. Docker 部署 (适合有服务器的玩家)

如果你熟悉 Docker,也可以用 Docker 快速部署:

# 拉取最新的镜像

docker pull xiangfa/deep-research:latest

# 运行容器 (简单版)

docker run -d --name deep-research -p 3333:3000 xiangfa/deep-research

# 运行容器 (带环境变量)

docker run -d --name deep-research \

-p 3333:3000 \

-e GOOGLE_GENERATIVE_AI_API_KEY=你的Gemini_API_Key \

-e ACCESS_PASSWORD=你的访问密码 \

xiangfa/deep-research

然后通过 http://你的服务器IP:3333 访问。

聊聊隐私这事儿再强调一下,隐私是 Deep Research 设计的核心考量之一。

• 默认本地优先:所有操作,包括你的研究主题、API Key(如果你在界面输入)、生成的报告,默认都只存在你的浏览器本地存储 (Local Storage) 中。我们不收集你的任何数据。

• 服务器模式可选:只有当你明确配置了服务器端的 API Key (.env 文件中的 GOOGLE_GENERATIVE_AI_API_KEY) 并选择使用服务器 API 模式时,请求才会通过服务器转发给 Google Gemini API。这种模式主要是为了方便部署和共享,或者解决本地网络访问 Google API 的问题。即使这样,你的研究内容本身我们也不会存储。

• 密码保护:如果你部署到公共服务器,强烈建议设置 ACCESS_PASSWORD,保护你的服务不被滥用。

你可以完全放心地用它来研究任何你想研究的主题,不用担心隐私泄露。

网址:告别熬夜搜文献!我用 Gemini 造了个 2 分钟出深度研究报告的 AI 神器! https://www.yuejiaxmz.com/news/view/977299

相关内容

开搜AI搜索深度分析报告中国睡眠研究报告2023: 熬夜已经成为大学生的常态

#健康#【告别熬夜 ...

分析师的黄昏?OpenAI推出AI Agent“深度研究”,主打“金融、科学、政策和工程等领域”

生活文化的研究报告

熬夜=慢性自杀,一图告诉你睡6小时和8小时的区别

2025年AI出行趋势研究报告

Gemini Live:Google最新推出的个人AI对话助手

运动20分钟能抵消熬夜伤害?专家:不建议熬夜后立刻运动

生产力提升30%!微软最大规模调研报告出炉,AI工具成打工人效率神器